[23′ Nature Article] Leveraging large language models for predictive chemistry

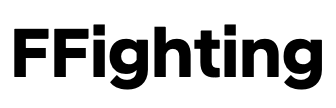

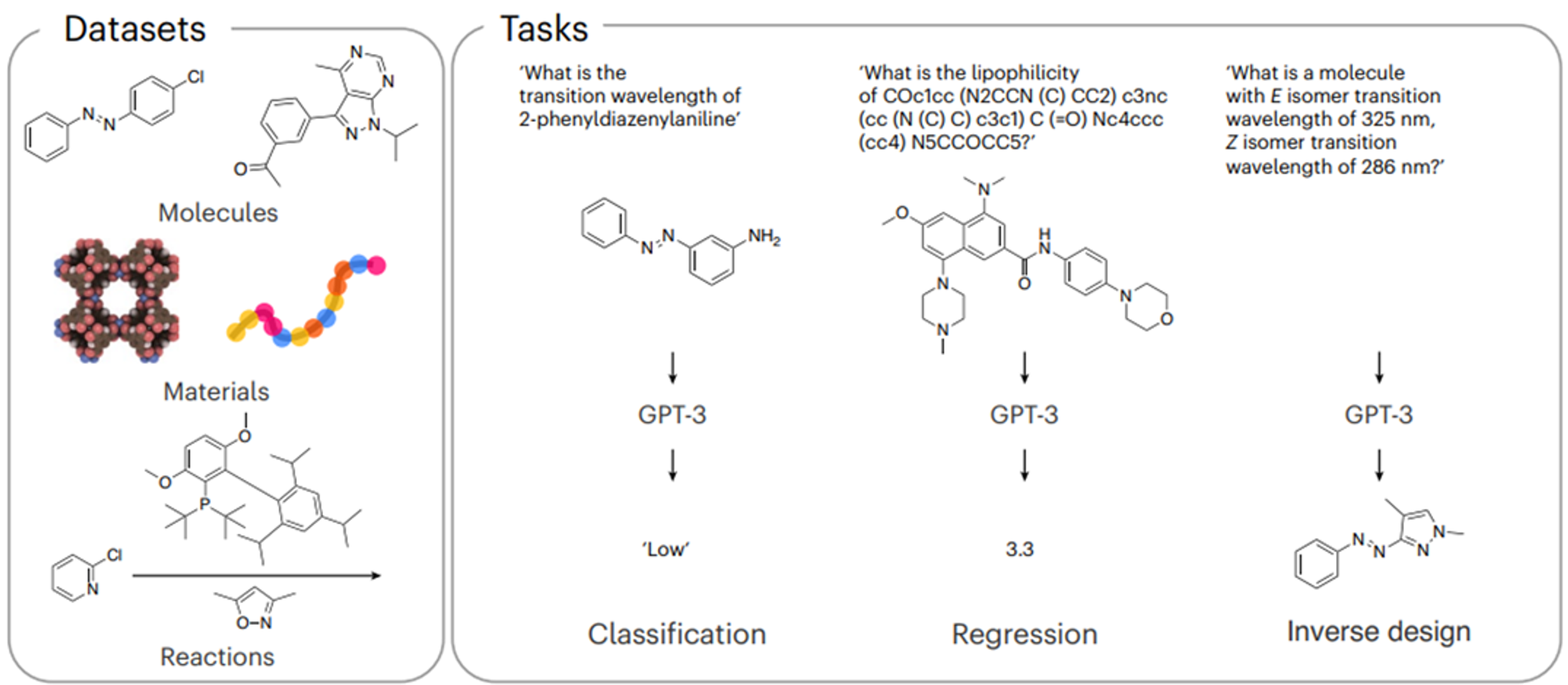

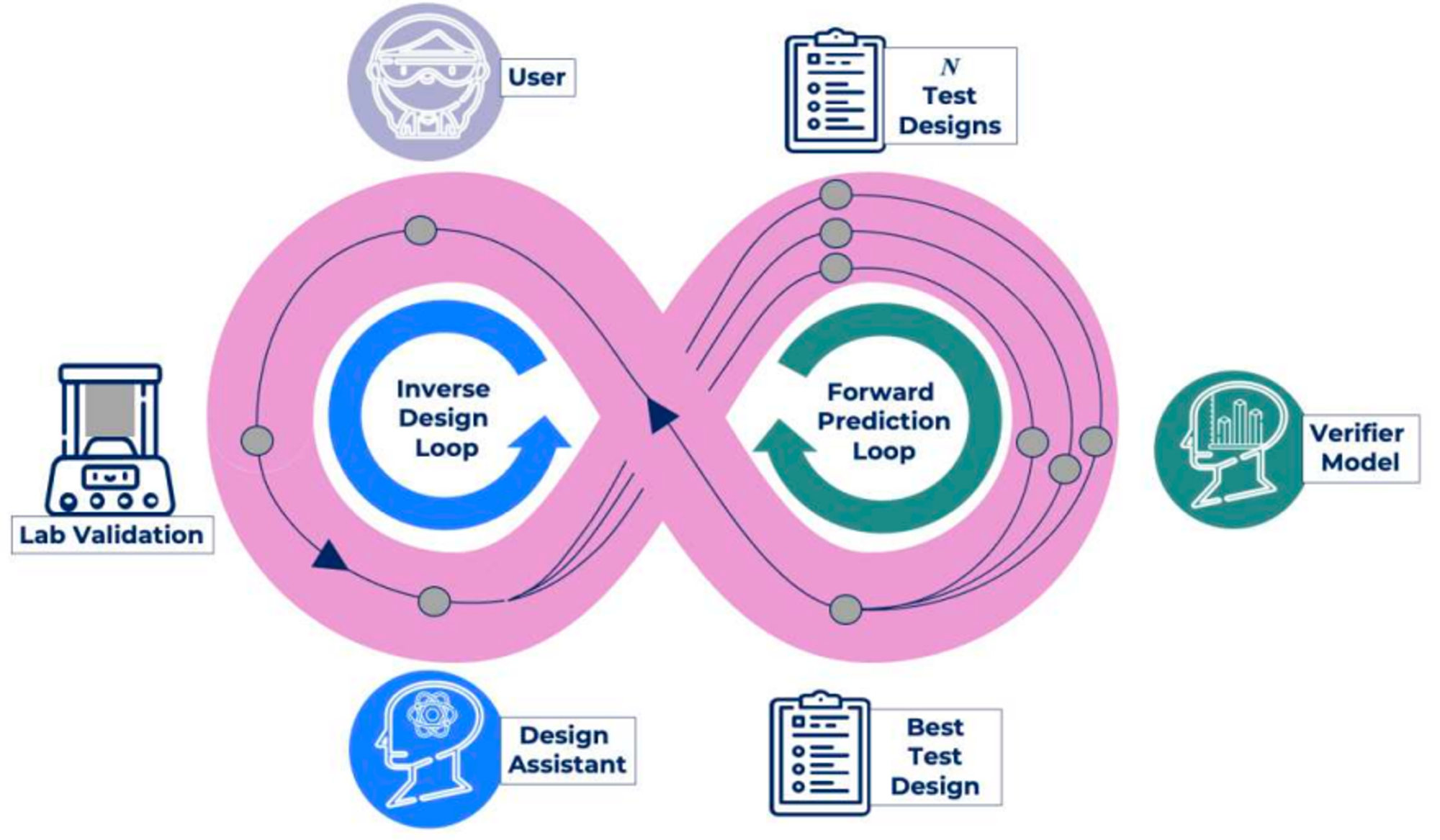

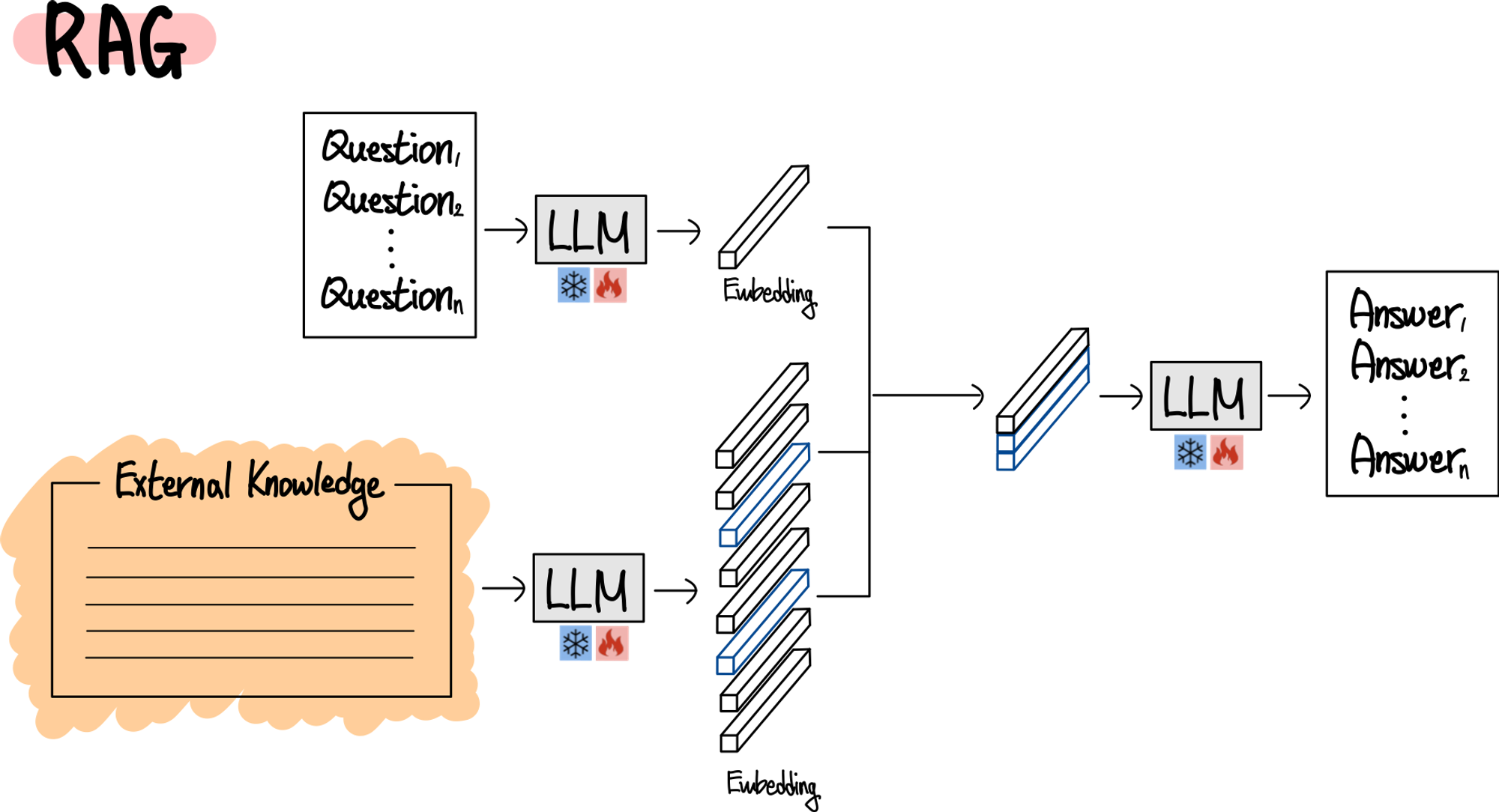

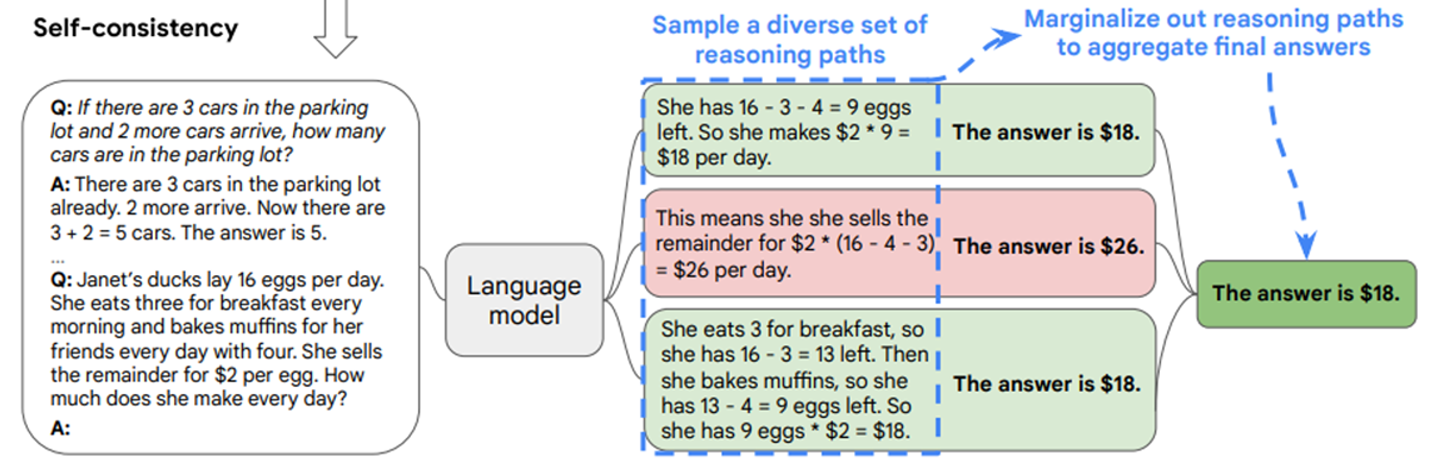

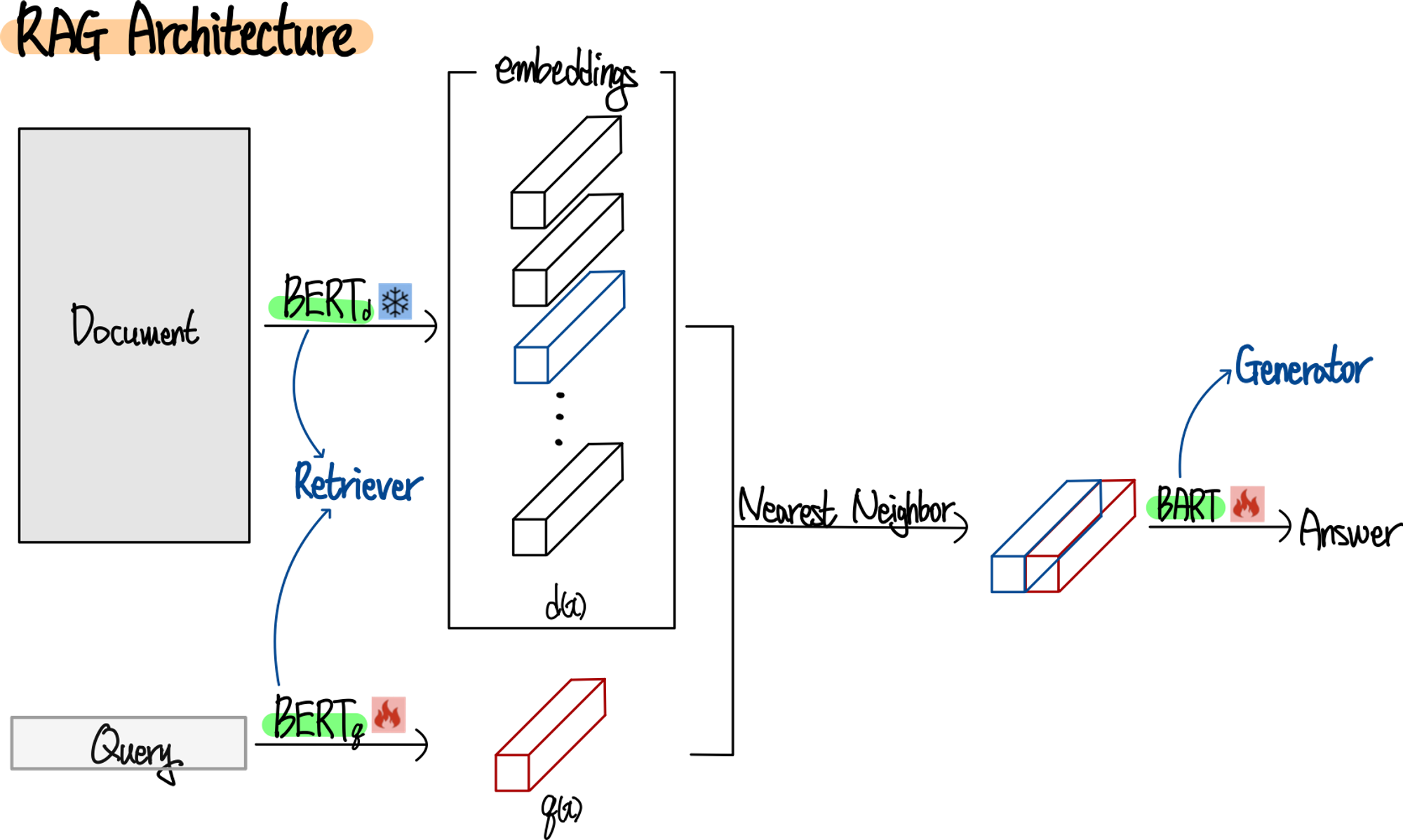

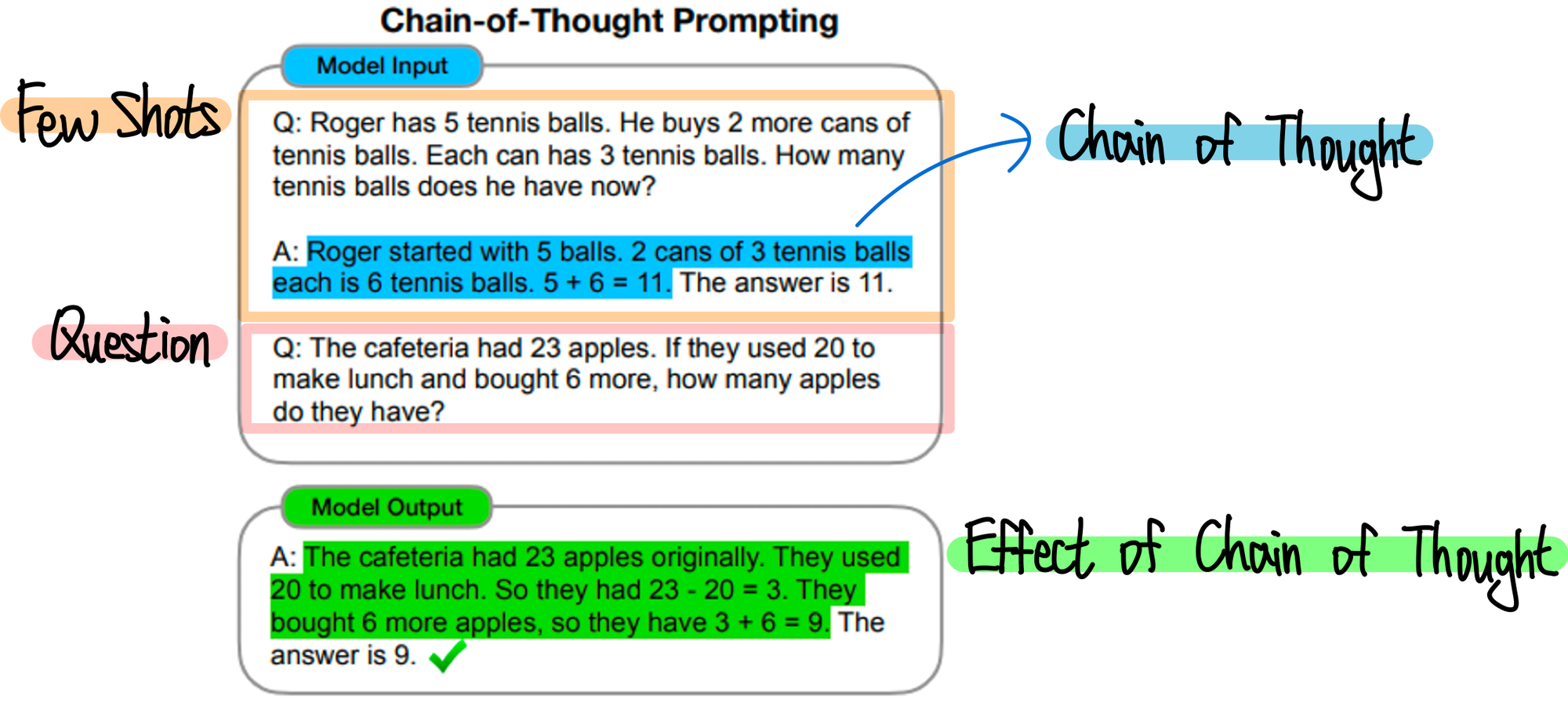

LLM을 활용하여 분자식을 예측하는 새로운 방법을 제안합니다. 이 방법은 분자 데이터를 자연어처럼 처리하여, 분자의 특성을 분류하고, 특성으로부터 분자식을 역추론하는 과정을 단순화합니다. LLM의 자연어 처리 능력을 이용해 분자식을 직접 입력으로 사용하며, 이를 통해 분자의 특성을 예측하거나 새로운 분자식을 설계합니다.